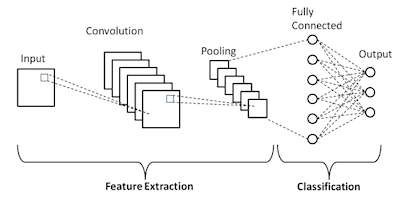

類神經網路根據資料從輸入節點至輸出節點的流向,可分為不同種類,以下列舉幾種較為常見的類型

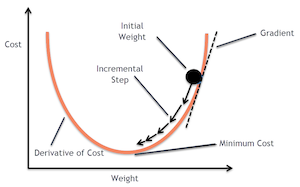

在類神經網路中,通常會使用損失函數(Loss Function)做為模型結果好壞的依據,梯度下降法為降低損失函數的一種最佳化方法,透過每次的偏微分迭代,向梯度最大的方向前進以尋求最佳解。

圖片來源:連結

反向傳播主要使用微積分中的連鎖律(Chain Rule)由網路末端計算誤差與權重間的關聯性,使得類神經網路收斂速度加快。

特徵地圖全部產生後,會進行池化(Pooling),池化目的為對每個特徵地圖中的最大值、平均值的重要數值進行粹取,並進行特徵圖降維。最後一步為進入全連接層(Fully Connected Layer)進行分類,全連接層中會有激勵函數(Activation Function)對接收到的資訊進行最後的分類。激勵函數也可使用於類神經網路架構的中間層數,以增加類神經網路架構的非線性程度,下篇文會對激勵函數進行詳細的介紹。